Librerie di crawler Web Java

Volevo creare un crawler web basato su Java per un esperimento. Ho sentito che fare un crawler Web in Java era la strada da percorrere se questa è la prima volta. Tuttavia, ho due domande importanti.

-

In che modo il mio programma "visiterà" o "si collegherà" alle pagine web? Si prega di dare una breve spiegazione. (Capisco le basi degli strati di astrazione dall'hardware fino al software, qui sono interessato alle astrazioni Java)

Quali librerie dovrei usare? Mi presumo di aver bisogno di una libreria per la connessione a pagine Web, una libreria per il protocollo HTTP/HTTPS e una libreria per l'analisi HTML.

11 answers

Questo è il modo in cui il tuo programma 'visita' o 'connetti' alle pagine web.

URL url;

InputStream is = null;

DataInputStream dis;

String line;

try {

url = new URL("http://stackoverflow.com/");

is = url.openStream(); // throws an IOException

dis = new DataInputStream(new BufferedInputStream(is));

while ((line = dis.readLine()) != null) {

System.out.println(line);

}

} catch (MalformedURLException mue) {

mue.printStackTrace();

} catch (IOException ioe) {

ioe.printStackTrace();

} finally {

try {

is.close();

} catch (IOException ioe) {

// nothing to see here

}

}

Questo scaricherà il sorgente della pagina html.

Per l'analisi HTML vedere questo

Crawler4j è la soluzione migliore per te,

Crawler4j è un crawler Java open source che fornisce una semplice interfaccia per la scansione del Web. È possibile impostare un crawler web multi-threaded in 5 minuti!

Anche visita. per ulteriori strumenti web crawler basati su java e una breve spiegazione per ciascuno.

Per analizzare il contenuto, sto usando Apache Tika .

In questo momento c'è un'inclusione di molti parser HTML basati su java che supportano la visita e l'analisi delle pagine HTML.

Ecco l'elenco completo del parser HTML con confronto di base.

Ti consiglio di utilizzare la libreria HttpClient. Puoi trovare esempi qui .

Preferirei crawler4j. Crawler4j è un crawler Java open source che fornisce una semplice interfaccia per la scansione del Web. È possibile impostare un crawler web multi-threaded in poche ore.

È possibile esplorare.apache droid o apache nutch per ottenere la sensazione di crawler basato su java

Sebbene utilizzato principalmente per applicazioni Web di Unit Testing, HttpUnit attraversa un sito Web, fa clic su link, analizza tabelle ed elementi del modulo e fornisce metadati su tutte le pagine. Lo uso per la scansione del Web, non solo per i test unitari. - http://httpunit.sourceforge.net /

Penso che jsoup sia migliore di altri, jsoup gira su Java 1.5 e versioni successive, Scala, Android, OSGi e Google App Engine.

Ecco un elenco di crawler disponibili:

Https://java-source.net/open-source/crawlers

Ma suggerisco di usare Apache Nutch

Dai un'occhiata a questi progetti esistenti se vuoi imparare come può essere fatto:

- Per maggiori informazioni:

]} - crawler4j

- gecco

- Norconex HTTP Collector

- sito ufficiale]}

- webmagic

- Ricerca e sviluppo]}

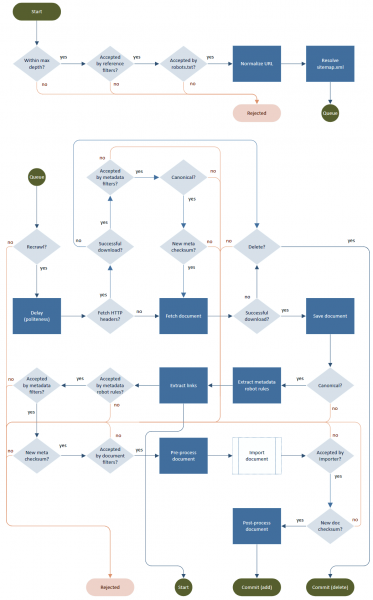

Un tipico processo crawler è un ciclo costituito da recupero, analisi, estrazione di link ed elaborazione dell'output (memorizzazione, indicizzazione). Anche se il diavolo è nei dettagli, cioè come essere "educato" e rispettare robots.txt, meta tag, reindirizzamenti, limiti di velocità, canonicalizzazione URL, profondità infinita, tentativi, rivisitazioni, ecc.

Diagramma di flusso per gentile concessione di Norconex HTTP Collector.